Директива Crawl-delay является одной из важных инструкций для поисковых роботов при сканировании сайта. Она определяет задержку между запросами к серверу, которую должен соблюдать поисковый робот при обходе страниц сайта. Таким образом, указывая crawl-delay, веб-мастер может контролировать частоту запросов и снизить нагрузку на свой сервер.

Директива Crawl-delay используется в файле robots.txt, который является текстовым файлом, размещенным на корневом уровне сайта и содержит инструкции для роботов по сканированию сайта. Поисковые системы, такие как Google и Яндекс, обращаются к файлу robots.txt перед началом сканирования сайта и соблюдают указанные в нем правила.

Использование директивы Crawl-delay особенно полезно для сайтов с большим объемом контента или ограниченными ресурсами. Если поисковый робот отправляет слишком много запросов к серверу в секунду, это может привести к повышенной загрузке сервера, медленной работе сайта или даже его недоступности для пользователей. Установка crawl-delay позволяет регулировать скорость сканирования и предоставляет более гибкий и эффективный контроль над процессом.

Роль директивы Crawl-delay в файле robots.txt

В файле robots.txt, который используется для указания инструкций по индексированию и сканированию сайта поисковыми роботами, директива Crawl-delay играет важную роль. Она определяет время задержки между запросами поискового робота к серверу, что позволяет бороться с проблемой превышения серверными ресурсами и необходимостью обрабатывать множество запросов слишком быстро.

С помощью директив Crawl-delay можно установить максимальное количество запросов, которое поисковый робот может выполнить в определенный промежуток времени. Это особенно полезно для серверов с ограниченными ресурсами, чтобы не нагружать их и не вызывать сбоев в работе сайта или сервера. Установка задержки между запросами позволяет контролировать нагрузку ботов на сервер и обеспечивает более стабильную работу ресурса.

Директива Crawl-delay может задаваться в секундах или в миллисекундах, в зависимости от требований поискового робота. Значение этой директивы должно быть установлено в соответствии с возможностями сервера и его скоростью обработки запросов. Однако следует помнить, что некоторые поисковые системы игнорируют или не поддерживают данную директиву.

Использование директивы Crawl-delay в файле robots.txt позволяет более гибко управлять сканированием и индексированием сайта поисковыми роботами, обеспечивая баланс между скоростью обработки запросов и нагрузкой на сервер. Это полезный инструмент для оптимизации работы сайта, особенно на серверах с ограниченными ресурсами или при необходимости ограничить скорость доступа к контенту.

Как использовать директиву Crawl-delay для оптимизации скорости сканирования?

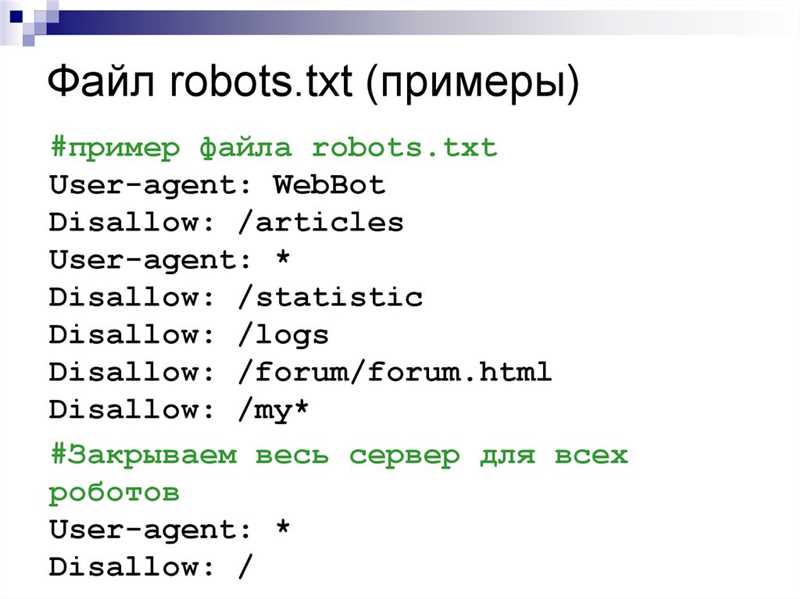

Чтобы использовать директиву Crawl-delay, необходимо добавить ее в файл robots.txt вашего сайта. Файл robots.txt представляет собой текстовый файл, который содержит инструкции для поисковых роботов о том, какой контент они должны или не должны сканировать.

Пример использования директивы Crawl-delay:

User-agent: * Crawl-delay: 10

В приведенном выше примере директива Crawl-delay устанавливает задержку в 10 секунд для всех поисковых роботов (* — это общая метка для всех роботов) на вашем сайте. Это означает, что каждый робот должен подождать 10 секунд перед отправкой следующего запроса на сервер.

Установка оптимальной задержки Crawl-delay зависит от конкретных требований вашего сайта и серверных ресурсов. Если ваш сервер имеет ограниченную пропускную способность или вы предпочитаете снизить нагрузку на сервер, вы можете увеличить значение задержки. В случае, если ваш сервер обладает высокой производительностью и способен обрабатывать большое количество запросов, вы можете уменьшить значение задержки или полностью отказаться от использования данной директивы.

Использование директивы Crawl-delay для оптимизации скорости сканирования поможет вам распределить нагрузку на сервер и предотвратить возможные проблемы с производительностью. Однако следует помнить, что директива Crawl-delay не гарантирует 100% контроля над скоростью сканирования, так как каждая поисковая система может реагировать на данную директиву по-разному.

В целом, использование директивы Crawl-delay является важным инструментом для оптимизации работы поисковых роботов на вашем сайте. Подбирая оптимальное значение задержки, вы сможете улучшить производительность сервера и обеспечить более эффективное сканирование контента роботами.

Наши партнеры: