Краулинг – это процесс, во время которого компьютерный робот, известный как веб-краулер или веб-паук, перебирает интернет-страницы в поисках информации. Этот процесс является одним из основных компонентов поискового движка, таких как Google. Краулеры работают автоматически и сканируют миллионы веб-страниц в сети, чтобы обновлять и создавать базы данных с информацией для поисковых запросов пользователей.

Управление роботами является важной и неотъемлемой частью работы веб-краулеров. Для того чтобы определить, какие страницы сканировать и как часто обновлять информацию, можно использовать различные техники управления. Например, можно указать краулеру следовать определенным правилам или настроить его на сбор конкретной информации с определенного веб-сайта. Также можно настроить краулер на работу с определенными файлами, такими как карты сайта, которые помогают краулеру определить структуру сайта и эффективно собирать информацию.

Краулинг открывает множество возможностей для использования роботов в различных областях. Например, в настоящее время многие компании используют роботов для мониторинга и анализа данных в социальных сетях. Они собирают информацию о мнениях пользователей, трендах и новостях, чтобы помочь компаниям принимать более информированные решения. Краулинг также может использоваться в торговле, медиа и многих других отраслях, где доступ к актуальным данным играет важную роль.

В данной статье мы рассмотрим, как работает краулинг, как управлять роботами и какие возможности у них есть для более эффективного сбора информации. Мы также поговорим о некоторых проблемах, с которыми сталкиваются разработчики роботов, и каких инструментов они могут использовать для решения этих проблем.

Краулинг: основные понятия и принципы

В процессе краулинга краулеры обычно начинают с небольшого набора известных веб-страниц, называемого seed-списком, а затем следуют ссылкам на другие страницы, которые они находят на этих страницах. Таким образом, они рекурсивно обходят пространство веб-страниц и извлекают информацию с каждой из них.

Одним из ключевых понятий в краулинге является политика обхода. Политика обхода определяет, какие страницы будут посещены краулером, в каком порядке и с какой периодичностью. Эффективность краулинга зависит от выбора правильной политики обхода, так как неверная политика может привести к нерациональному использованию ресурсов или пропуску важной информации.

Еще одним важным понятием в краулинге является обработка контента. Краулеры должны уметь анализировать содержимое веб-страниц для извлечения информации. Обработка контента может включать извлечение текста, изображений, ссылок, метаданных и других элементов страницы. Часто краулеры используют различные алгоритмы и техники для эффективной обработки контента и извлечения нужной информации.

Краулинг является важной технологией, на которой базируется работа многих поисковых систем и онлайн-сервисов. Краулеры позволяют автоматически собирать, индексировать и обновлять информацию со всего Интернета, обеспечивая быстрый и удобный доступ к ресурсам для пользователей.

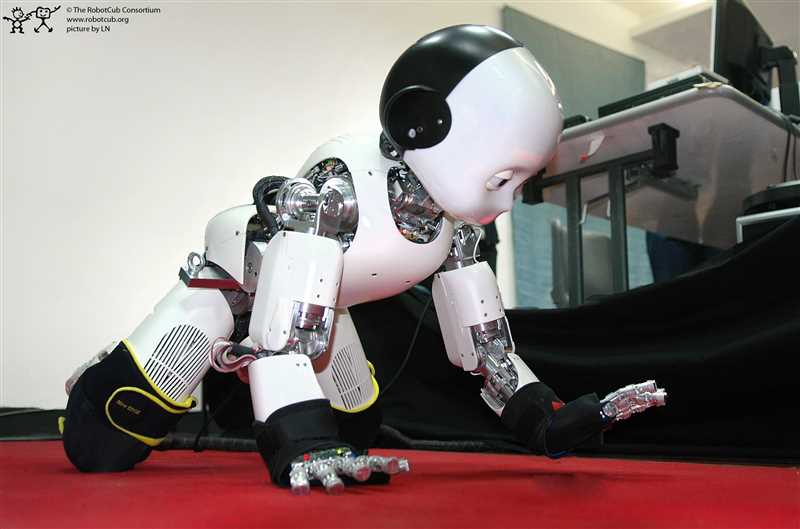

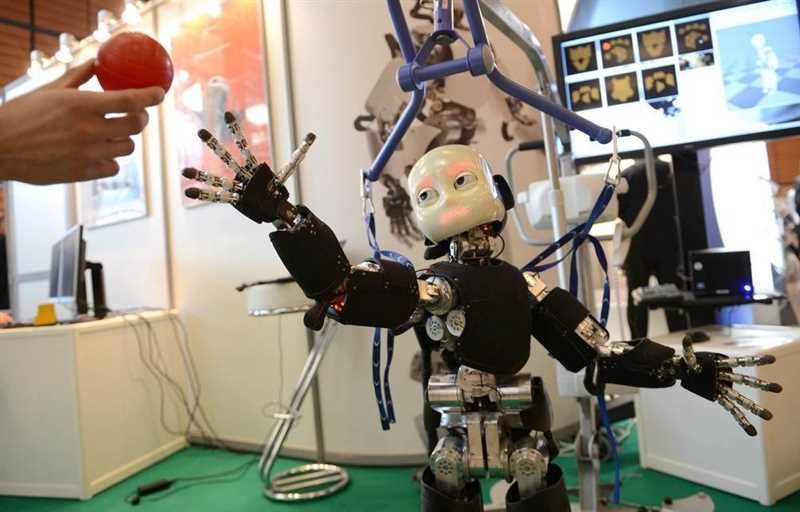

Управление поведением роботов

Существует несколько подходов к управлению поведением роботов. Один из них — это использование простых правил или условий, которые определяют, как робот должен реагировать на различные ситуации. Этот метод называется «реактивным управлением». Он позволяет роботу быстро адаптироваться к новым ситуациям, но может быть ограничен в возможностях решения сложных задач.

Другой подход — это использование более сложных алгоритмов и моделей, которые позволяют роботу планировать свое поведение и принимать решения на основе собранных данных. Этот метод называется «обратным управлением». Он может быть более гибким и способным решать сложные задачи, но требует более сложных вычислений и может быть менее быстрым в адаптации к новым ситуациям.

В обоих случаях важно иметь возможность программировать роботов и настраивать их поведение в соответствии с требуемыми задачами. Для этого разработчики могут использовать языки программирования, API и библиотеки, которые предоставляются производителями роботов. Кроме того, существует множество открытых исходных кодов, фреймворков и алгоритмов, которые позволяют разработчикам создавать и управлять своими собственными роботами.

В целом, управление поведением роботов — это комплексная задача, которая требует сочетания различных подходов и методов. Разработчики и инженеры в этой области постоянно работают над улучшением процесса управления и создания более эффективных и многофункциональных роботов.

Наши партнеры: