Создание и оптимизация сайта – основная задача веб-разработчиков и маркетологов. Однако, есть ситуации, когда требуется закрыть сайт или его отдельные страницы от индексации поисковыми системами. Бывает, что некоторые страницы содержат конфиденциальную информацию, которую необходимо скрыть от посторонних глаз. Также, существует возможность временного или постоянного закрытия сайта для обновления контента или проведения технических работ.

Существует несколько способов решения этой проблемы. Одним из наиболее популярных способов является использование файла robots.txt. Он предназначен для указания правил поисковым роботам, ограничивающих действия индексации и индексации содержимого сайта.

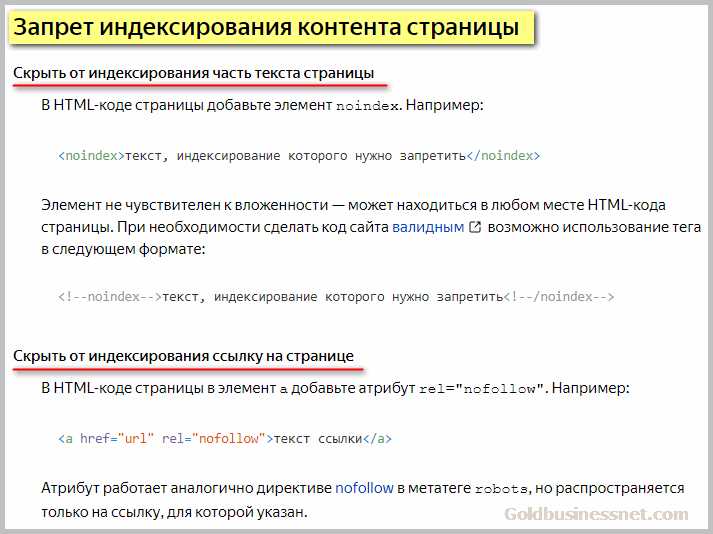

Другим способом является использование мета-тега «noindex» в html-коде страницы, который сообщает поисковым роботам, что данная страница не должна попадать в поисковую выдачу. Таким образом, можно выбирать, какие страницы сайта необходимо отключать от индексации.

Файл robots.txt

Основная структура файла robots.txt состоит из двух частей: User-agent и Disallow.

- User-agent — определяет поисковые роботы, к которым будут применены следующие инструкции. Например, * обозначает всех роботов, а Googlebot — только поискового робота Google.

- Disallow — определяет страницы или разделы сайта, которые не должны быть индексированы. Запись Disallow: /private/ запретит индексацию всего содержимого папки «private».

Также в файле robots.txt можно использовать дополнительные директивы, такие как Allow, Sitemap и Host. Директива Allow позволяет разрешить доступ к определенным разделам сайта, которые были запрещены в иной части файла. Директива Sitemap указывает на расположение файла карты сайта, а директива Host позволяет указать основное доменное имя сайта.

Мета-тег noindex

<meta name="robots" content="noindex">

Таким образом, поисковые системы, включая Google, Яндекс и Bing, будут игнорировать данную страницу и не добавят ее в свои поисковые результаты. Это особенно полезно, когда вы хотите скрыть временные страницы, страницы с конфиденциальной информацией или такие страницы, которые дублируются на других сайтах.

Однако следует отметить, что использование мета-тега noindex не является гарантией того, что поисковые системы не проиндексируют страницу. Некоторые поисковые роботы могут проигнорировать этот тег или создать копию страницы в своей базе данных, несмотря на запрет индексации. Поэтому, если вам необходимо полностью исключить страницу из поисковых результатов, рекомендуется использовать другие методы, такие как использование файла robots.txt или парольной защиты.

Использование директивы X-Robots-Tag

Для использования директивы X-Robots-Tag необходимо добавить соответствующий HTTP-заголовок к каждой странице сайта или к файлу robots.txt, если нужно задать настройки для всего сайта. Например, если вы хотите закрыть от индексации определенную страницу, вам нужно добавить следующий заголовок:

X-Robots-Tag: noindexС помощью директивы X-Robots-Tag можно задавать и другие настройки. Например, вы можете указать, что страницу нужно закрыть от индексации, но разрешить ее кэширование:

X-Robots-Tag: noindex, noarchiveИли вы можете указать, что страницу можно индексировать, но запретить ее кэширование:

X-Robots-Tag: index, noarchiveИспользование директивы X-Robots-Tag является эффективным способом контроля над поведением поисковых роботов на вашем сайте. Она позволяет закрыть от индексации только те страницы, которые вам нужно, не внося изменений в файл robots.txt. Кроме того, данная директива поддерживается основными поисковыми системами, включая Google и Яндекс.

Таким образом, использование директивы X-Robots-Tag является одним из практических решений закрытия сайта или его части от индексации. Она позволяет гибко настраивать поведение поисковых роботов и обеспечивает контроль над индексацией страниц.

Наши партнеры: